Photo by Daniel Cheung on Unsplash,本文来自微信民众号:量子位(ID:QbitAI),作者:方栗子

这是一只AI生出的小AI。

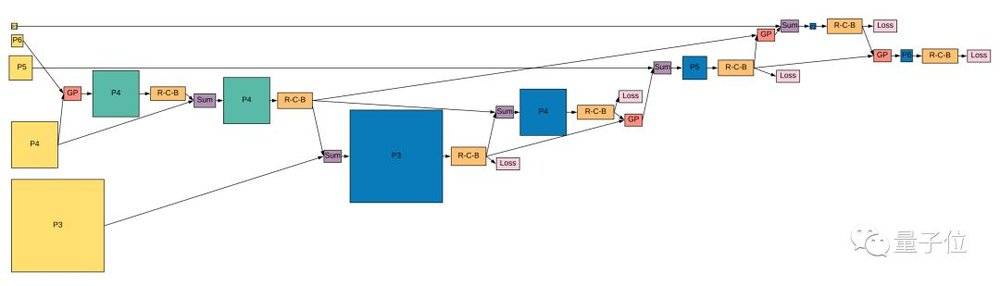

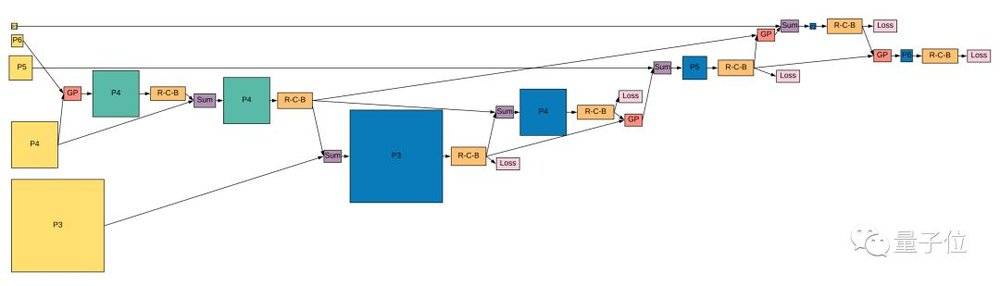

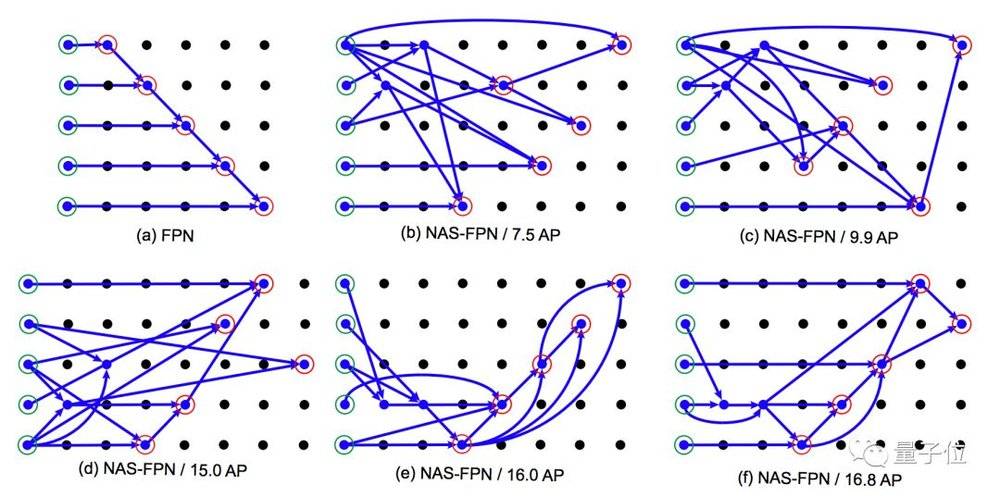

谷歌大脑的Quoc Le团队,用神经收集架构搜刮 (NAS) ,发明了一个目的检测模子。长如许:

△ 看不清请把手机横过去

它的准确率和速率都超过了大先辈Mask-RCNN;也超过了别的两只行业精英:FPN和SSD。

模子叫做NAS-FPN。大佬Quoc Le说,它的长相完整在设想以外,非常前卫:

△ 喜信宣布一日,已收成600颗心

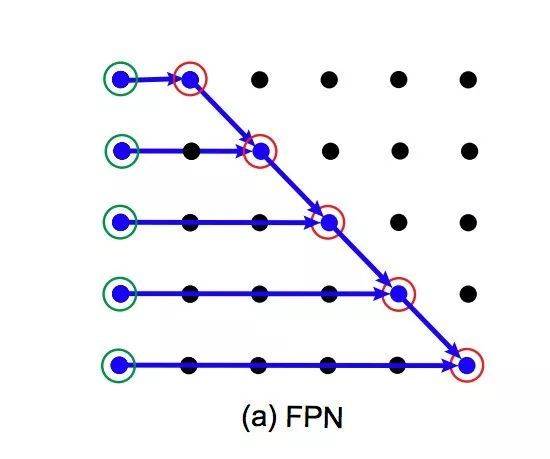

AI的脑洞果真和人类不一样。对照一下,目的检测界的传统要领FPN (特性金字塔收集) 长如许:

谷歌大脑说,虽然收集架构搜刮 (NAS) 并不算新鲜,但他们用的搜刮空间异乎寻常。

如何搜出来?

在NAS-FPN涌现之前,地球上最壮大的目的检测模子,架构都是人类手动设想的。

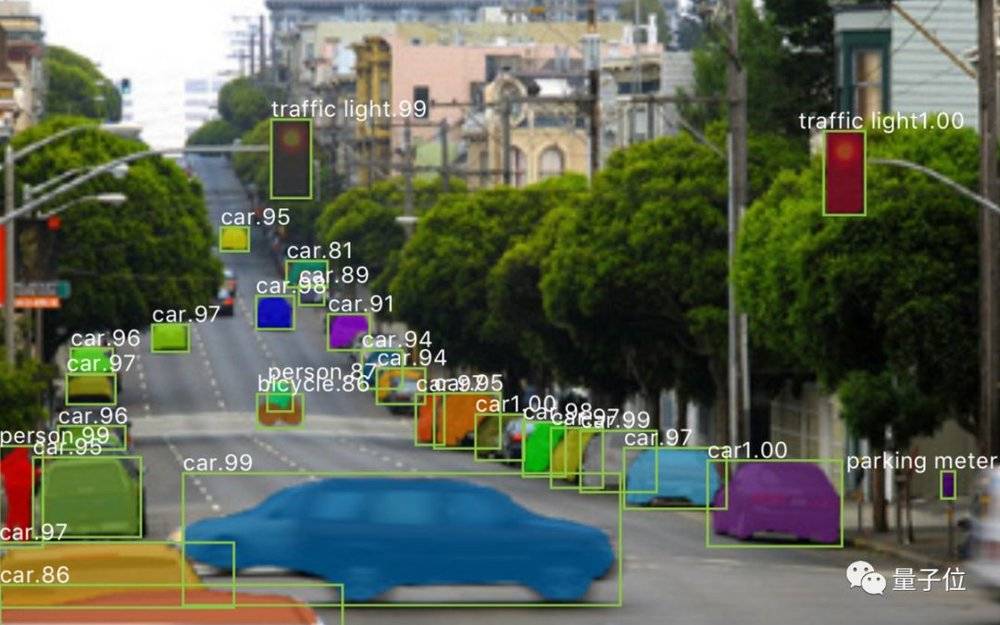

△ 这是Mask-RCNN的结果

NAS是一种自动调参的要领,调的不是练习超参数,是收集架构超参数:好比收集若干层、每层都是甚么算子、卷积层里的过滤器巨细等等。

它能够在许多许多分歧的架构里,疾速找到机能最好的那一个。

以是,要把目的检测的经常使用架构FPN (特性金字塔收集) 和NAS结合起来,发明那只最凶猛的AI。

但题目是搜刮空间太大,特性高出许多分歧的标准。

因而,团队基于RetinaNet框架,设想了一个新的搜刮空间:

这里,一个FPN是由许多的“兼并单位 (Merging Cells) ”构成的。

是要把输入的分歧标准/分辨率的特性层,兼并到RetinaNet的表征里去。

详细如何兼并?这是由一个RNN控制器来决议的,经由四个步调:

一是,从输入里任选一个特性层;

二是,从输入里再选一个特性层;

三是,挑选输出的特性分辨率;

四是,挑选一种二进制运算,把两个特性层 (用上一步选定的分辨率) 兼并起来。

第四步有两种运算可选,一种是加和 (sum) ,一种是全局池化 (Global Pooling) 。两个都是简朴、高效的运算,不会附加任何带练习的参数。

一个Cell就如许兼并出来了,但这只是中心结果。把它加到适才的输入列内外,和其他特性层排在一起。

然后,就能够从新选两个特性层,反复上面的步调一、二、四,连结分辨率稳定。

(团队说,若是要制止选到雷同分辨率的两个特性层,就不要用步长8。2和4是对照适宜的步长。)

就如许,不停地天生新的Cell。

住手搜刮的时刻,末了天生的5个Cell,会构成“被选中的FPN”出道。

那末题目来了,搜刮甚么时刻能停?

不是非要悉数搜刮完,随时都能够退出。横竖分辨率是稳定的,FPN是能够随便扩大的。

团队设定了Early Exit (提早退出) 机制,用来衡量速率和准确率。

终究宣布NAS-FPN的,是AI跑了8,000步以后,拔取最末5个Cell天生的收集。回忆一下:

从原始FPN (下图a) 最先,它走过的路大概是如许的:

跑得越久,天生的收集就越弯曲。

模子如何?

NAS-FPN能够依托于种种骨架:MobileNet,ResNet,AmoebaNet……

团队挑选的是AmoebaNet骨架。

那末,用COCO test-dev数据集,和那些壮大的先辈比一比高清大图检测结果。

竞赛结果宣布:

NAS-FPN拿到了48.3的AP分,超过了Mask-RCNN,而且用时更短 (右侧第二列是时候) 。

别的一场竞赛,是挪动检测 (320x320) ,NAS-FPN的轻量版本,跑在MobileNet2骨架上:

超过了凶猛的先辈SSD轻量版,虽然,照样没有遇上YOLOv3。

△ YOLOv3过往结果展

不外,打败Mask-RCNN已是值得庆贺的造诣了。

One More Thing

NAS既然如此高能,应当已搜刮过许多器械了吧?

谷歌大脑的另一位成员David Ha列出了7种:

1) 基于CNN的图象分类器,2) RNN,3) 激活函数,4) SGD优化器,5) 数据扩增,6) Transformer,7) 目的检测。

并发射了直击魂魄的发问:下一个被搜的会是甚么?

他的同事摘得了最佳答案:NAS啊。

△ NAS

论文传送门:https://arxiv.org/pdf/1904.07392.pdf

本文来自微信民众号:量子位(ID:QbitAI),作者:方栗子

*文章为作者自力看法,不代表虎嗅网态度

本文由 量子位 受权 虎嗅网 宣布,并经虎嗅网编纂。转载此文请于文首标明作者姓名,连结文章完整性(包孕虎嗅注及其他作者身份信息),并请附上出处(虎嗅网)及本页链接。原文链接:https://www.huxiu.com/article/295286.html

未依照范例转载者,虎嗅保存追查响应义务的权益

将来眼前,你我还都是孩子,还不去下载 虎嗅App 猛嗅立异!,返回网站首页

关注我们:请关注一下我们的微信公众号:扫描二维码

,公众号:aiboke112

,公众号:aiboke112版权声明:本文为原创文章,版权归 所有,欢迎分享本文,转载请保留出处!

评论已关闭!